AI

- 注意力机制

- Transformer、Bert等,解码器编码器

- 预训练模型,原理,实践

- 微调方法,评估

- CS231n完成 (ass1)

- cs231n assign2

- cs231n assign3

1.14

早上好,今日计划

- 完成下学期选课

- 动手实践知识图谱构建

- 理解学长发的论文和项目的源码,有机会的话尝试复现论文实验

- 日常的阅读/单词学习

实际执行:

- [x] 完成下学期选课

- [ ]

动手实践知识图谱构建实操难度较大,改为补充理论知识。 - [ ]

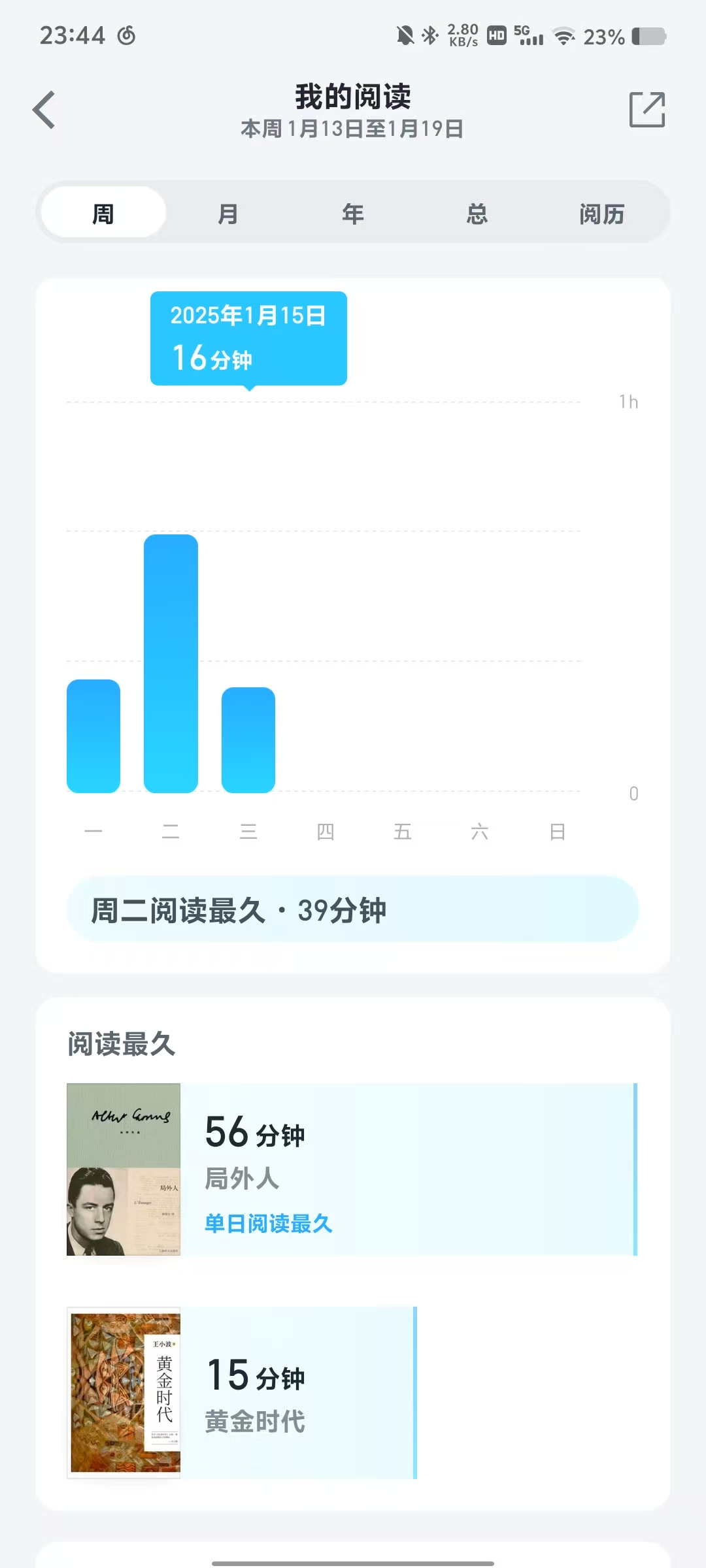

理解学长发的论文和项目的源码,有机会的话尝试复现论文实验缺乏理论支撑,改为继续完成CS231n assignment1 - [x] 日常的阅读/单词学习 => 读完 加缪《局外人》,法语打卡

1.15

今日计划:

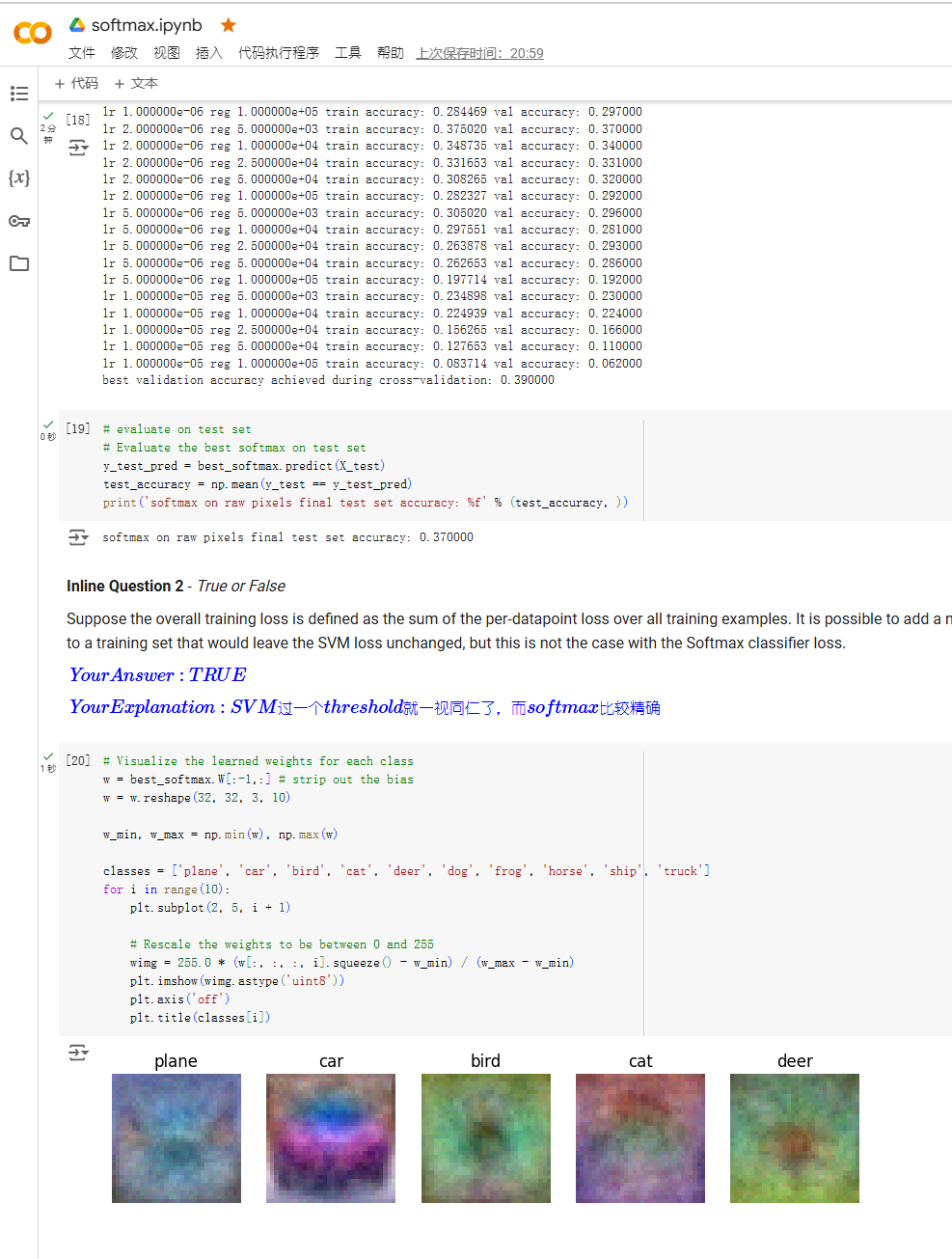

- [x] CS231n softmax回归部分完成(即Assignment1完成)

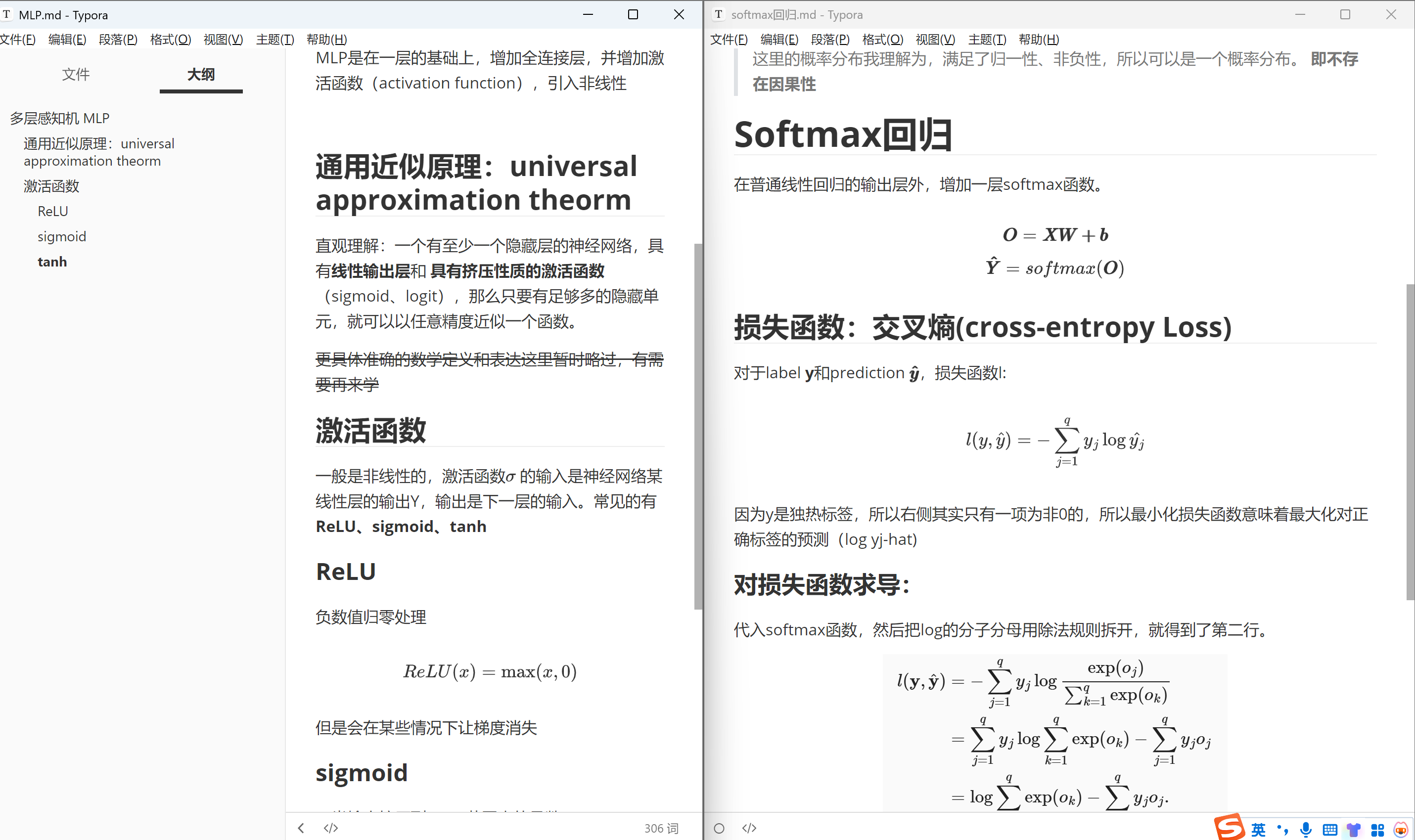

- [x] 《动手学深度学习》第四章 多层感知机 理论 + code(完成前两节)

- [x] 简单了解Transformer整体架构 + 注意力机制

- [x] 法语打卡

- [x] 日常阅读

1.16

今日计划:

- [x] 日常阅读

- [x] 法语打卡

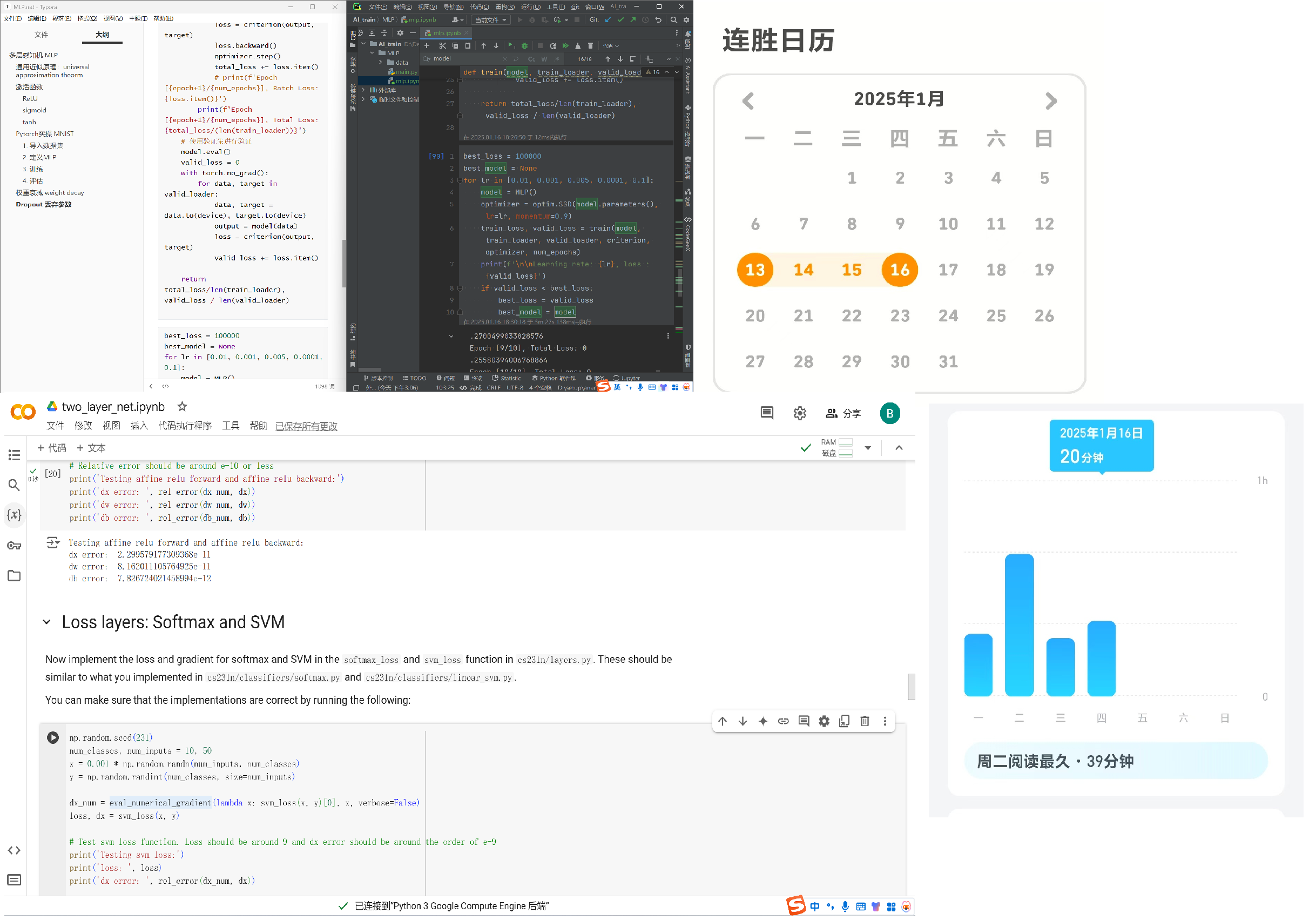

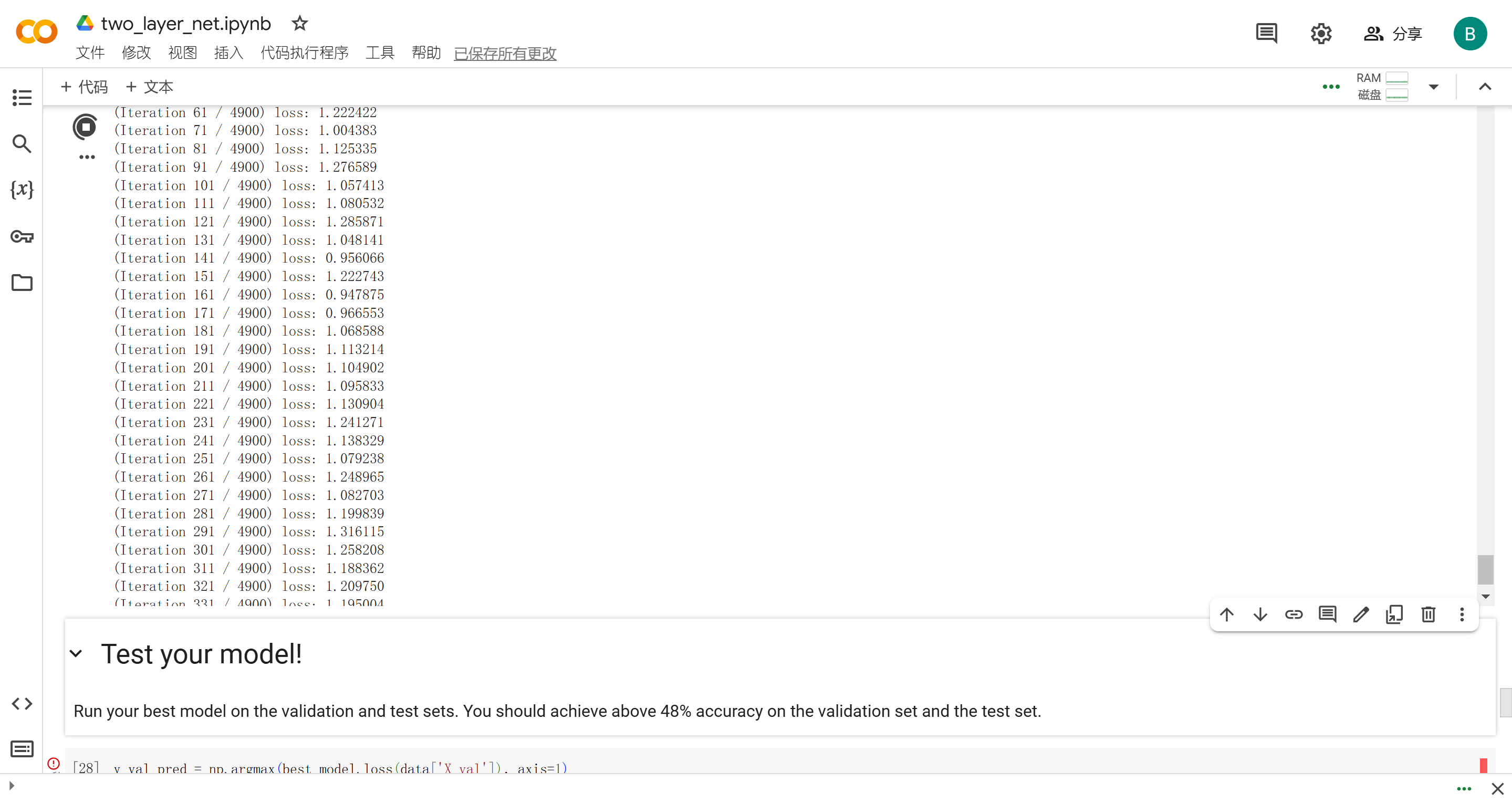

- [ ] cs231n,2layer NN完成(部分完成,研究了一下矩阵求导)

- [x] 多层感知机学习 到 4.6 dropout

- [x] 和老师确认一下课程和实验测试

1.17

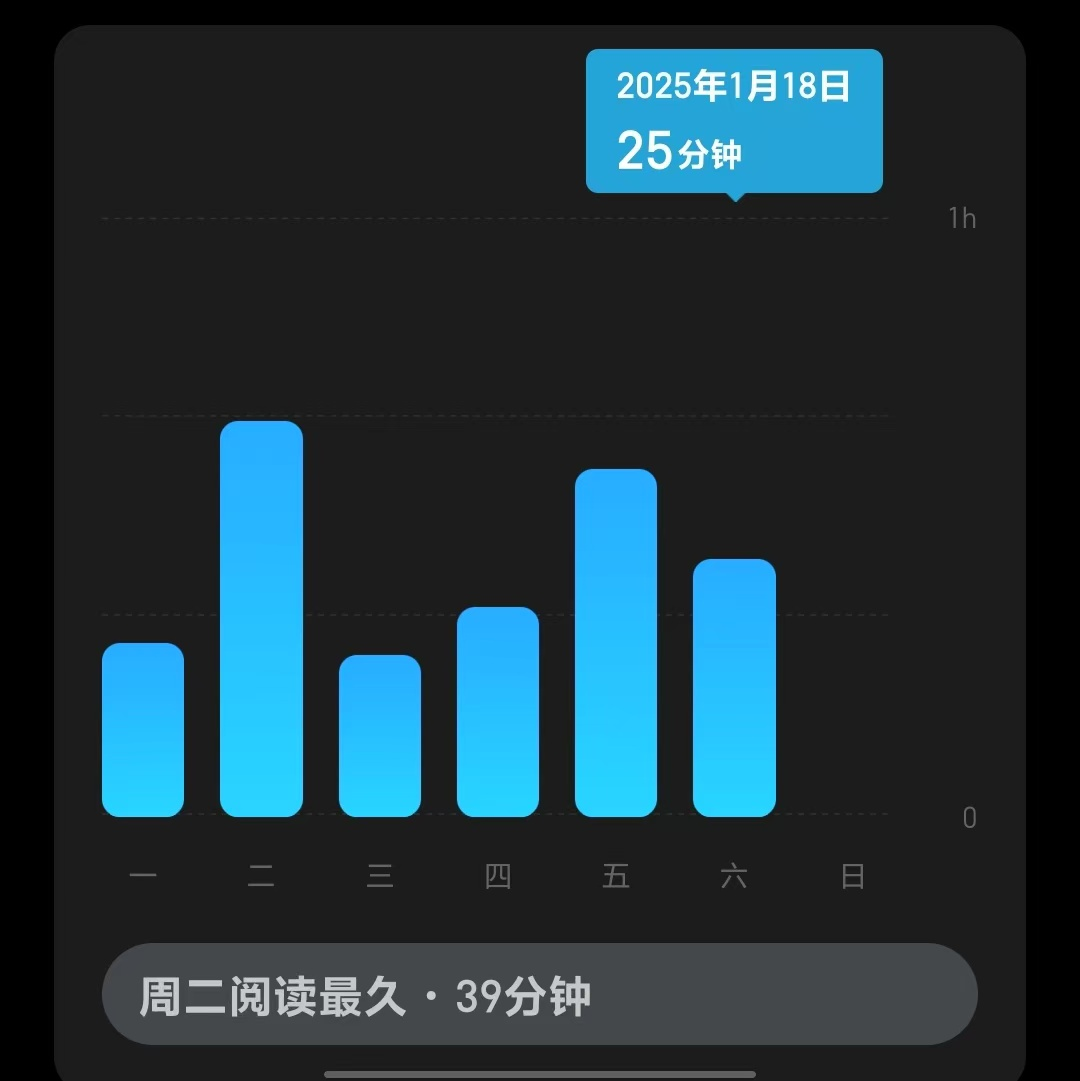

- [x] 日常阅读

- [x] 法语打卡

- [x] cs231n two layer节作业完成

- [ ] MLP 第四章学完(鸽了,今天突发情况,在和某老师argue成绩…)

- [x] 出门散步

1.18

- [x] 日常阅读

- [x] 法语打卡

- [x] 和老师argue:已完成流程

- [x] MLP 第四章学完

- [x] (突发新增)昨天的two layer好像没做对,重新修改、训练、完善

1.19

- [x] 阅读

- [x] 法语打卡

- [x] cs231 feature完成,Assign1完成

- [ ] 继续学习《动手学深度学习》,进度随缘

1.20

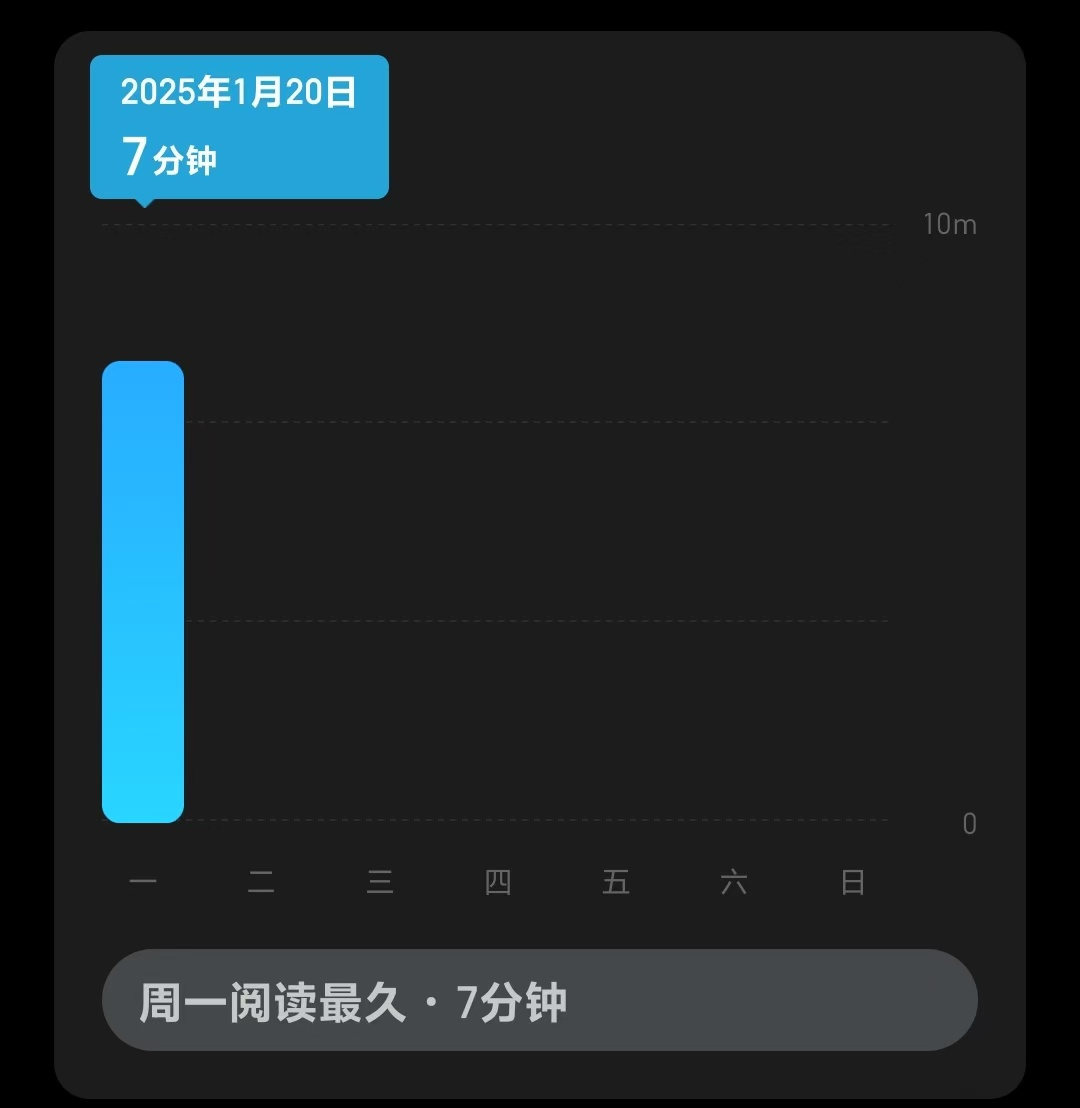

- [x] 阅读(今天忙,有些少)

- [x] 法语打卡

- [x] cs231n 中文note optimization上下看完 (超额完成,多看了一节)

- [ ] 继续学习《动手学深度学习》,进度随缘

1.21

- [x] 阅读

- [x] 法语打卡

- [x] cs231n 神经网络1 note 上+下 (完成并总结笔记)+ 神经网络2(可选=> 未完成)

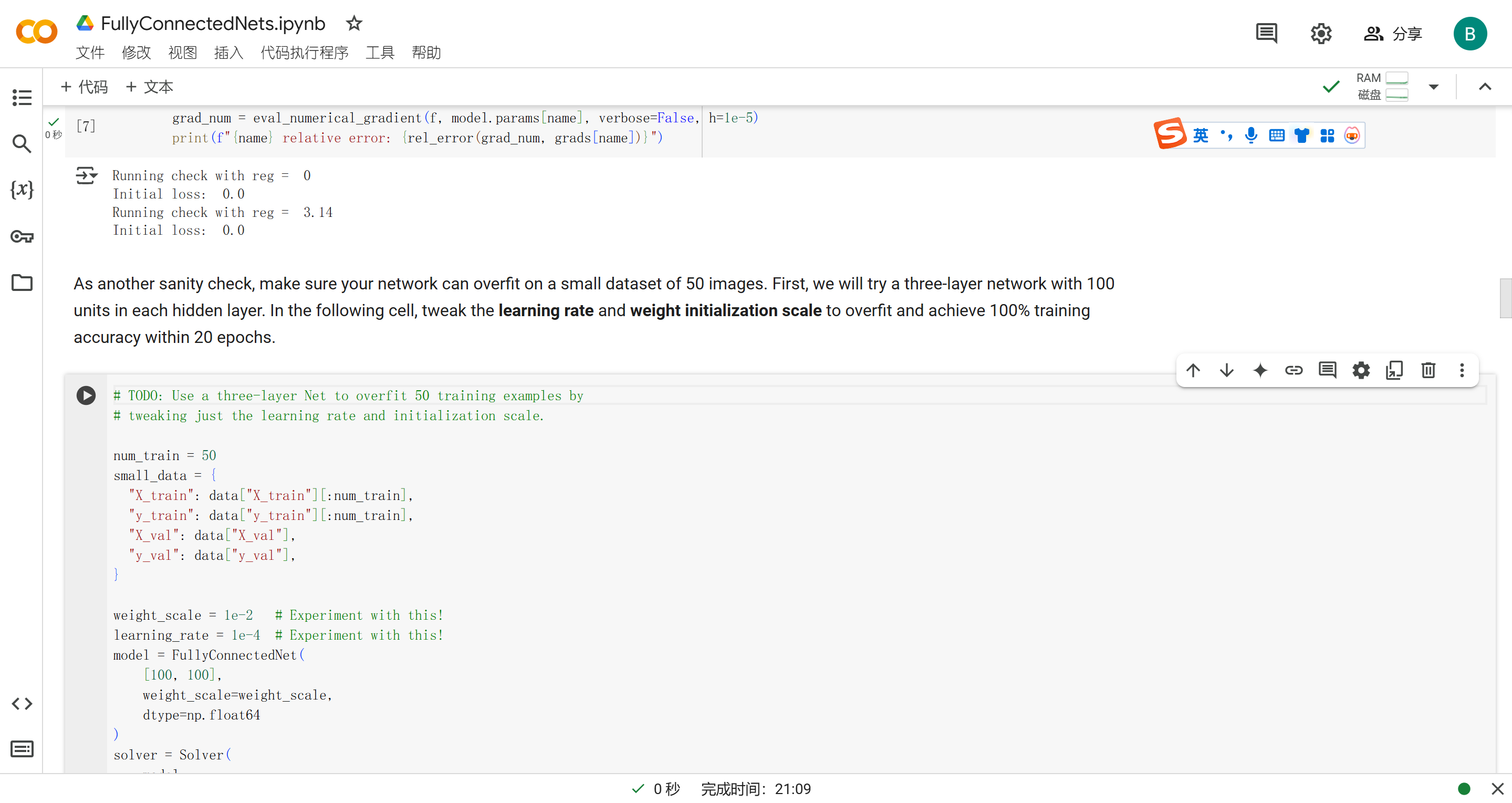

- [ ] assign2 FullyConnectedNets 完成(就开了个头。。)

1.22

- [x] 阅读

- [x] 法语打卡

- [x] cs231n 神经网络2 + 3上下 note(下没看完,23号继续)

- [ ] FullyConnectedNet 完成(咕咕)

1.23

今天没有提前列计划,比较佛系,记录一下今天完成了什么

- [x] 阅读

- [x] 法语打卡

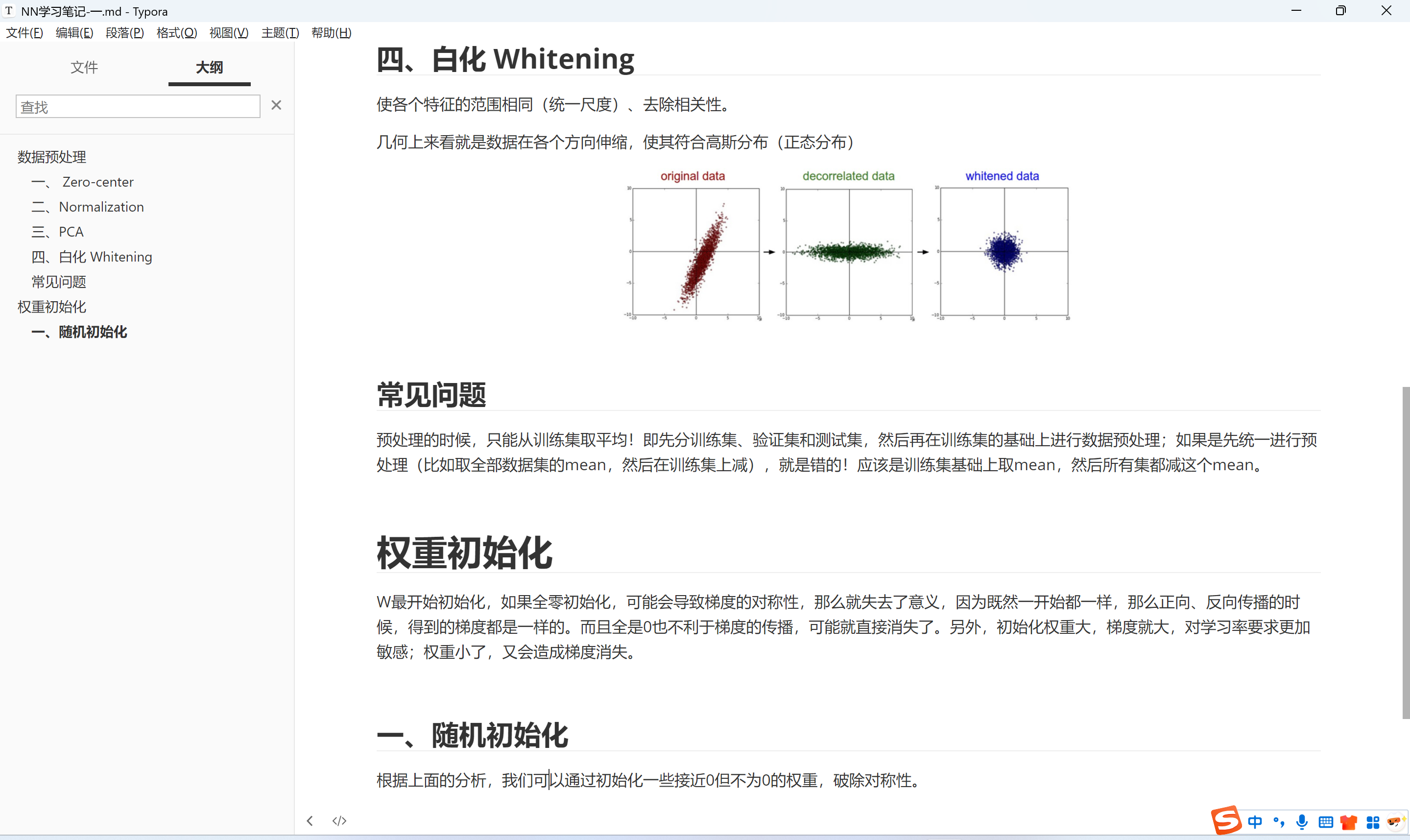

- [x] 神经网络训练前准备 笔记总结(1/3)

1.24

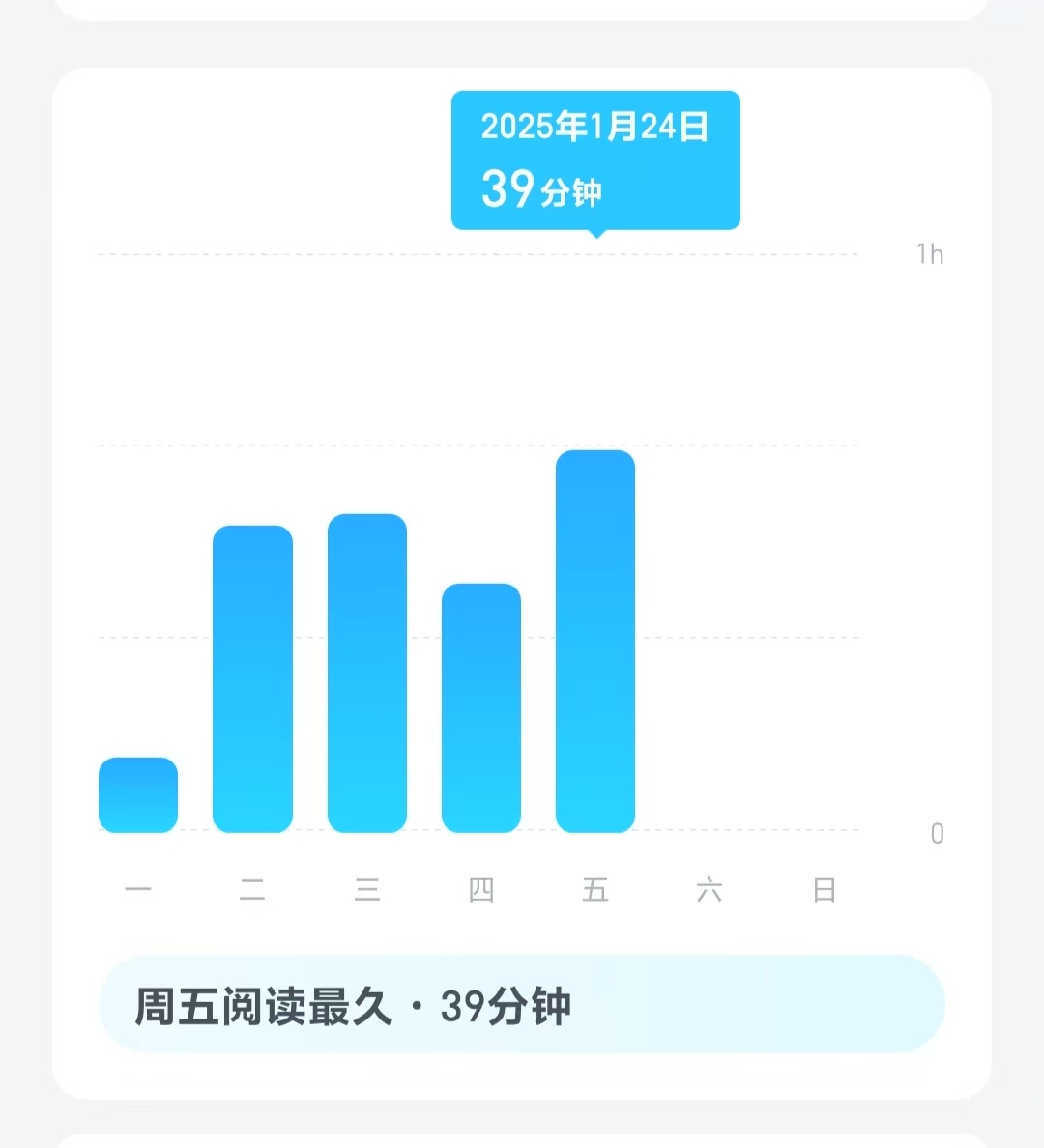

- [x] 阅读

- [x] 法语打卡

- [ ] 完成神经网络训练前操作note总结(上午)

- [x] 完成judge平台课程实验测试

- [ ] 简单浏览、分析github项目代码 - lei’s 组:分析功能、结构,意义,简单使用。

1.25

- [ ] 阅读

- [x] 法语打卡

- [x] 训练前note总结

- [ ] 简单分析lei’s group项目代码

1.26

- [x] 阅读

- [x] 法语打卡

- [ ] 继续神经网络note学习

- [ ] lei’s group项目代码分析

- [x] (突发)和学长/老师对接项目(所以咕了上面的两项)

2.7

- [x] 法语打卡

- [x] 阅读

- [x] 尝试部署小微预训练模型 + 实现SFT过程(明天租个机器重新来过…)

- [ ] 学习注意力机制相关理论

- [x] 了解Transformer的大概,以及decoder encoder原理(明天总结博客)

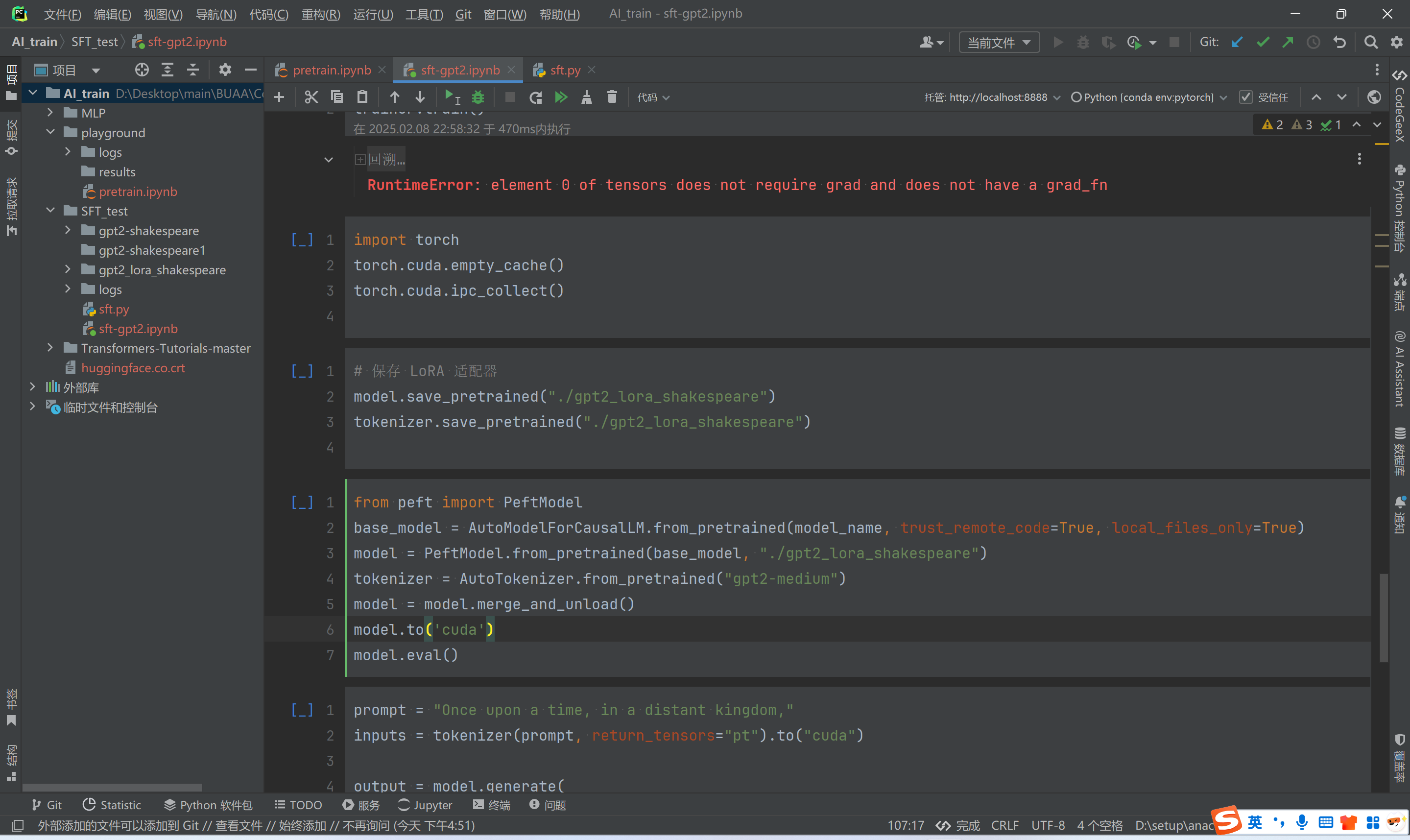

2.8

- [x] 法语打卡

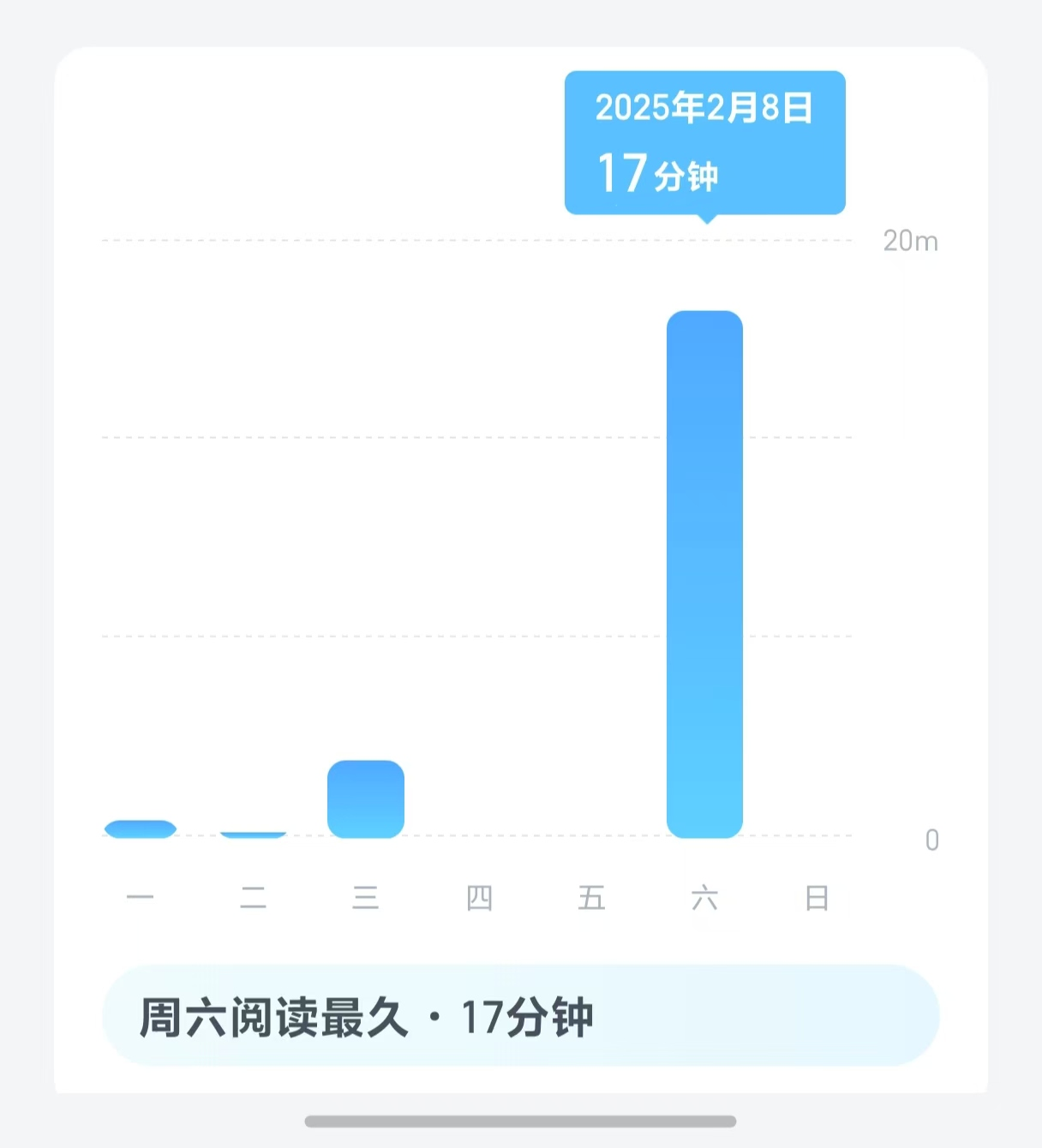

- [x] 阅读

- [ ] 租赁(√)、配置云算力平台(×)

- [x] 预训练GPT2 + tinyShakespeare(但是不知道为什么效果不好,还把模型搞烂了)

TODO: LLaMA-Factory, vLLM推理框架? OpenRLHF, Chainlang

如果您喜欢此博客或发现它对您有用,则欢迎对此发表评论。 也欢迎您共享此博客,以便更多人可以参与。 如果博客中使用的图像侵犯了您的版权,请与作者联系以将其删除。 谢谢 !