简单记录每种Normalization方法的数学定义、直观理解、区别和用法,以及效果

一、 BatchNorm

应该是第一个提出的Normalization方法,参考 Batch normalization: Accelerating deep network training by reducing internal covariate shift

他的归一化以batch为单位,每个feature单独做Normalization(1d情况下)。

1. 数学定义

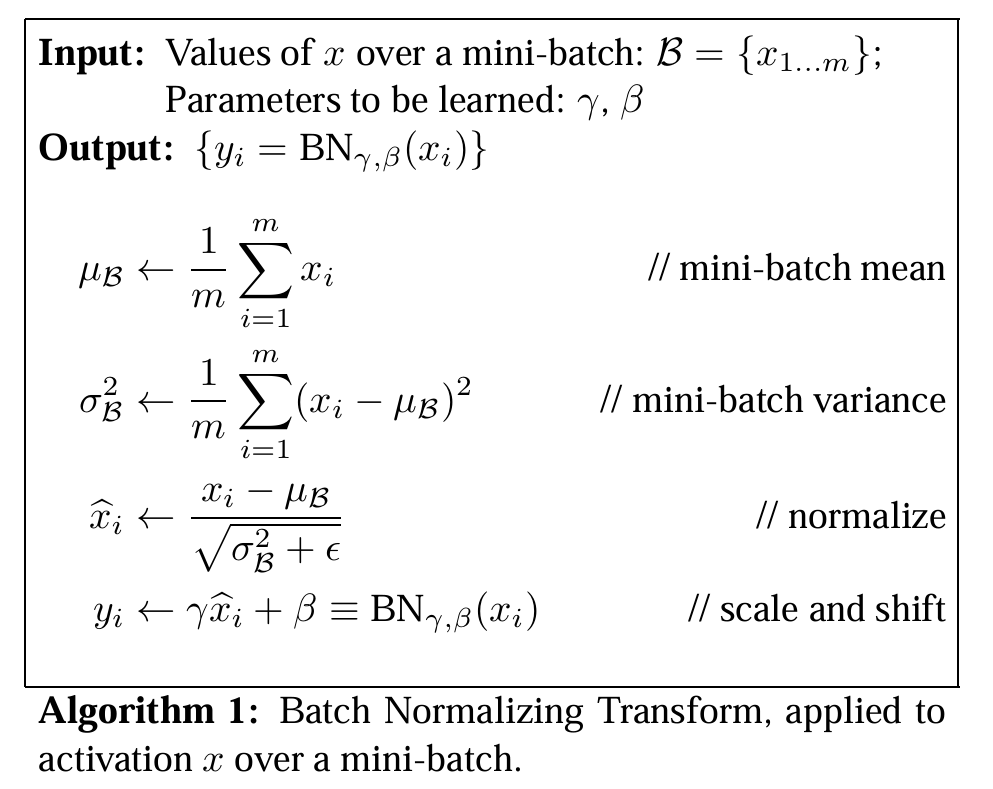

对于$bs=m$的batch,一次BN变换算法如下(这里其实是对于输入中的一个feature考虑的,比如$x^{(k)}$,然后省略了这个k):

2. 直观理解

BN就是对一个batch中的输入进行归一化,因此依赖于batchSize,如果bs太小就会效果很差。另外因为他每个feature单独做Normalization,所以feature之间实际上

如果您喜欢此博客或发现它对您有用,则欢迎对此发表评论。 也欢迎您共享此博客,以便更多人可以参与。 如果博客中使用的图像侵犯了您的版权,请与作者联系以将其删除。 谢谢 !