线性代数

矩阵求导

特征值和特征向量

特征值分解

review: $Av = \lambda v$, $\lambda$ 是特征值, $v$是特征向量,特征值代表特征向量有多重要,特征向量表示了该“特征”的内涵。

要求$A$必须是方阵($n\times n$)

分解后,有$A=W\Sigma W^{-1}$,其中$\Sigma$为对角阵,从左到右特征值依次减小,对应$W$中就是n个列向量就是对应的特征向量,描述矩阵变化方向(从主到次)。

Spectrum 谱

一个矩阵特征值的集合。

奇异阵

对于一个方阵$A$,有:

A是奇异阵 = A对应行列式为0 = A列向量线性相关 = A不可逆

在特征值分解的时候好像(还没搞懂)因为不可逆性需要用伪逆。

奇异值分解 SVD

对于方阵的特征值分解很好,但是非方阵怎么办呢?

于是有了奇异值分解。(这里讨论实数矩阵,理论如果考虑复数的话,V应该是V*,V的共轭转置矩阵)

$$

A_{m\times n} = U_{m\times m}\Sigma_{m\times n} V_{n\times n}^T

$$

其中$\Sigma$仍然是对角阵(注意:虽然它不是方阵,但是同样可以是“对角阵”,即$\Sigma[i][i]$处有值,其他地方为0,$0\leq i \leq min(m,n)$),大概长这样:

$$

\left[

\begin{matrix}

\sigma_1 & 0 & 0 \

0 & \sigma_2 & 0 \

0 & 0 & \sigma_3 \

0 & 0 & 0

\end{matrix}

\right]

$$

其中这些$\sigma$称为奇异值。

求解 U 和 V

奇异值分解本质是想要对非方阵也能进行特征提取和分解,因此我们试图用某种方法“近似”进行特征值分解==> 让A变成方阵最好(纯口胡)。

对$A^TA$这个方阵求特征值:

$$

(A^TA)V=\lambda V

$$

对$AA^T$这个方阵求特征值:

$$

(AA^T)U=\lambda U

$$

这样就求出了U和V,然后奇异值$\sigma_i=\sqrt{\lambda_i}$,因为最多有$p=min(m,n)$,所以其实就是看m和n谁大,就从对应的$AA^T$或$A^TA$里面的特征值里(少的那个)开根即可。

SVD 应用之 主成分分析 (PCA)

该部分参考:

- https://blog.codinglabs.org/articles/pca-tutorial.html 就是这里的Latex公式似乎挂了,有点难受。

- https://zhuanlan.zhihu.com/p/37777074 但是为什么我和他X的定义是转置的呢,我习惯一行是一个样本,列是特征。

PCA,试图给数据降维,直观来讲,从我们人类容易想象的二维变一维,相当于“拍扁”到一个方向轴,如果想要降维还保留信息,自然是希望这些投影后的点不重合(分开,就可以辨别),其实就是要方差最大。

而对于压缩到不止一个维度(假设k维)时,肯定希望k个维度尽可能正交(与线性相关相对,表示更多信息),这时候方差就应该进化成协方差。

在每个维度减去维度的均值后,协方差矩阵有一个很好的性质(如果X是整体时分母n-1为n):

$$

Cov = \frac{1}{n-1}X^TX

$$

注意这里最后要让协方差矩阵是m*m的,即特征之间的方差,注意是$XX^T$还是$X^TX$。

(略去很多PCA中的数学推导,还没研究)

通过找到协方差矩阵中最大的d个特征向量(对应最大的方差),就可以降维了。但是样本量很大的时候这样太慢了。

有一些SVD的实现算法(但我并不了解)可以不先求$X^TX$,也能求出右奇异矩阵V,这样就有了特征值和特征向量。

条件数 condition number

简单理解参考 神经网络优化:病态矩阵与条件数 , 病态问题及条件数

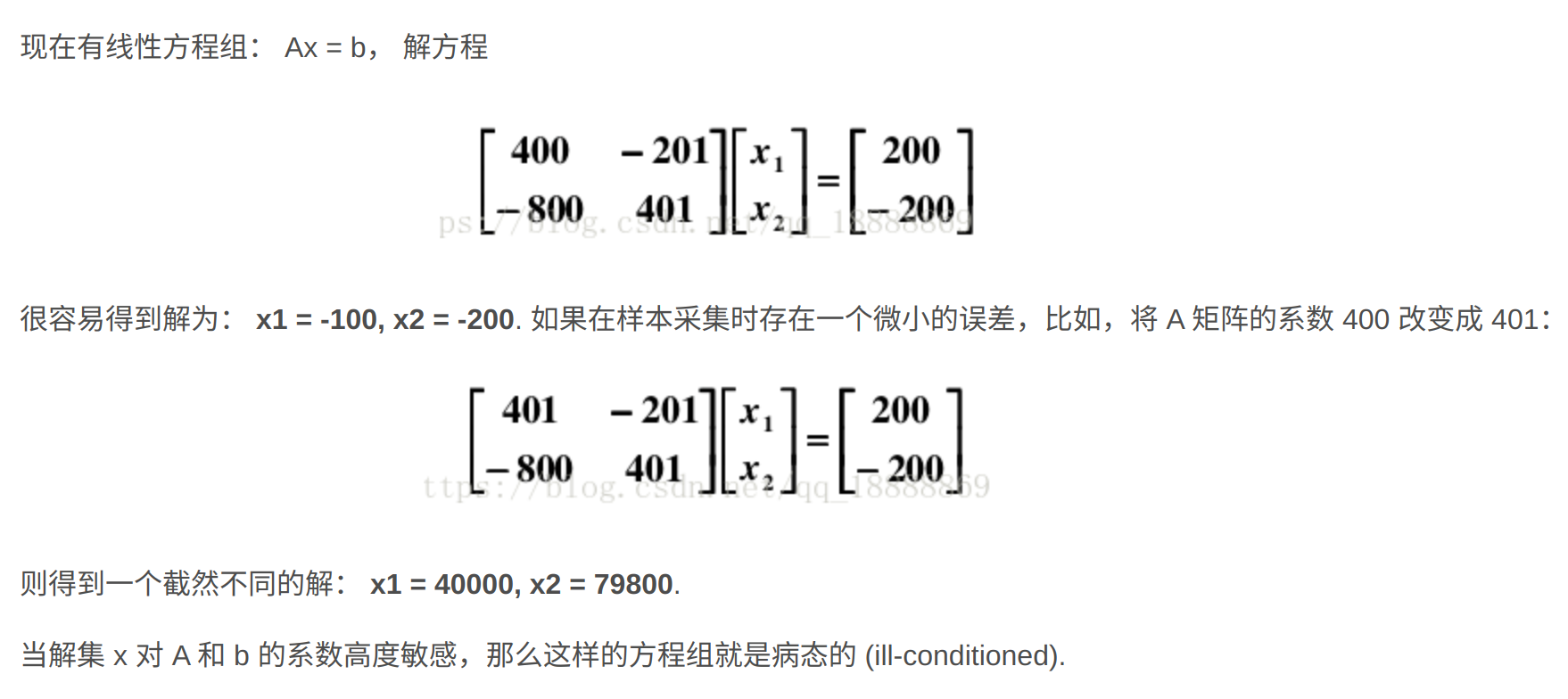

矩阵的条件数表示该矩阵在数值计算过程中稳定性、敏感性的指标,比如求解$AX=b$的线性方程组时,假如A稍微变化一点,X的变化会不会很大(很大:条件数大,敏感,病态;很小:条件数小,不敏感,良态)

上面参考的博客的例子对于理解很有帮助:

定义:

$$

\kappa(A)=||A^{-1}|| \cdot ||A||

$$

在优化问题中,我们常常选取l2矩阵范数,此时为$A^TA$最大特征值与最小特征值的比。

$$

\kappa(A) =||A^{-1}||2\cdot ||A||2 \

= \frac{\lambda{max}(A)}{\lambda{min}(A)}

$$

一般分析海森矩阵H的条件数。

克罗内克内积 Kronecker product

对于两个矩阵$A(m\times n), B(p\times q)$,A和B的K内积定义为:

$$

A\otimes B =

\left(

\begin{matrix}

a_{11}B & … & a_{1n}B \

\vdots & \ddots & \vdots \

a_{m1}B & … & a_{mn}B

\end{matrix}

\right)

$$

是一个$(mp\times nq)$的分块矩阵。

中英对照

moment : 矩 (一阶矩、二阶矩:概统)

如果您喜欢此博客或发现它对您有用,则欢迎对此发表评论。 也欢迎您共享此博客,以便更多人可以参与。 如果博客中使用的图像侵犯了您的版权,请与作者联系以将其删除。 谢谢 !